NOTA DE TAPA

Estudio de sensibilidad del esquema catalítico

para una unidad de hidrotratamiento de gasoil

Predicción de parámetros para la planificación técnica y económica.

A partir de ensayos en plantas piloto y su contraste con datos reales de operación, se analizan los efectos de cambios en la carga sobre el desempeño y la vida útil del catalizador, generando criterios prácticos para anticipar ajustes operativos y evaluar escenarios de planificación.

Por Fernando Giménez, María Primavera Monsalvo, Hernán Laurito, y Gustavo Trubiano (YPF)

Este trabajo fue seleccionado en el 7.º Congreso Latinoamericano y del Caribe de Refinación.

- Introducción

La unidad HTGB de Hidrotratamiento de Gas Oil de CIIEM (Complejo Industrial Ingeniero Enrique Mosconi) está destinada a la producción de diésel con ultrabajo azufre. El esquema catalítico actual de la unidad es un esquema convencional de hidrotratamiento y fue seleccionado mediante una evaluación técnica económica basada en los resultados de la performance técnica obtenida en las unidades piloto de YPF. En esa oportunidad compitieron 5 proveedores de tecnología, resultando todas las propuestas aptas para los requisitos solicitados.

El objetivo de este estudio es analizar el impacto de cambios en la calidad de carga y cambios en el caudal (5 casos) sobre la temperatura de inicio de ciclo y la longitud del ciclo para el esquema catalítico próximo a cargarse.

El nuevo esquema catalítico cargado en la unidad es igual al esquema que fue cargado en el ciclo anterior por lo que los resultados de este estudio pudieron ser validados con los datos del ciclo operativo que concluyó en marzo de 2025 y que se inició en 2021.

Contar con la información que surge de este estudio es fundamental para conocer la flexibilidad del sistema catalítico para el próximo ciclo operativo de la unidad. Es sin duda una ventaja operativa conocer anticipadamente cómo responderá la unidad ante cambios en calidad y caudal de carga y cuál será el impacto aproximado sobre las principales variables operativas.

- Desarrollo

Estudios en plantas piloto de YPF

- Descripción de la unidad.

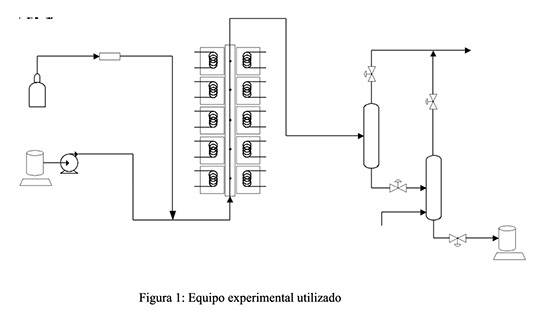

En la figura 1 se presenta un esquema del equipo utilizado para los ensayos de sensibilidad:

La unidad consta de un reactor de lecho fijo que opera de manera isotérmica. La longitud y el diámetro interno del reactor son de 143 cm y 2.54 cm, respectivamente. La longitud del reactor está dividida en cinco zonas, cada una de las cuales es calefaccionada eléctricamente y tiene las siguientes funciones:

Zona 1: Llena de partículas inertes, se utiliza para calentar la carga a la temperatura de reacción deseada y para proporcionar una distribución uniforme.

Zonas 2, 3 y 4: Destinadas a contener el catalizador y el diluyente.

Zona 5: También llena de partículas inertes.

Entre cada sección se inserta lana de material cerámico para mejorar la distribución del fluido. La unidad está equipada con un separador de alta presión y un separador de baja presión, dotado de un sistema de estripeo de H₂S con nitrógeno.

El equipo puede operar hasta 200 barg y 550 °C de temperatura, y puede funcionar en flujo ascendente o descendente.

Los procedimientos de secado, mojado, sulfuración y estabilización se realizan según las especificaciones proporcionadas por el proveedor de tecnología.

Una vez activado y estabilizado el catalizador, la unidad se ajusta operativamente a las condiciones deseadas para iniciar los ensayos.

- Metodología de testeo y análisis

A continuación, se describe brevemente la metodología de ensayo utilizada para el estudio de sensibilidad en las unidades piloto de YPF.

Los ensayos consistieron en evaluar el nivel de actividad del esquema catalítico en su estado SOR (a través de la WABT SOR necesaria para lograr la especificación deseada en el producto), luego se lleva a cabo una desactivación acelerada en condiciones controladas y posteriormente se mide nuevamente la actividad que corresponderá a la WABT de fin de ciclo. Con esta información es posible calcular la velocidad de desactivación que experimenta el esquema catalítico cuando es sometido a diferentes calidades de carga.

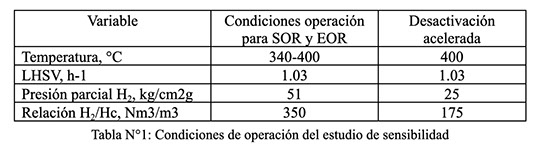

Las condiciones experimentales en las que se llevaron a cabo los estudios de sensibilidad son representativas de la unidad industrial.

En la tabla N°1 se resumen estas condiciones:

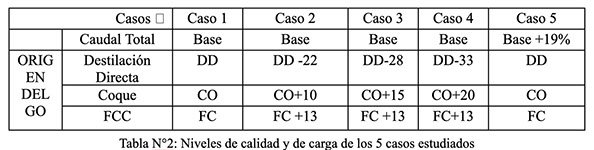

Se estudió el impacto de 5 casos que difieren en calidad de carga y nivel de carga (caudal) sobre la temperatura de operación y sobre la longitud de ciclo.

La tabla N° 2 indica los niveles de calidad y carga de los 5 casos estudiados. En la tabla, DD, CO, FC y CC representan los % en volumen en la carga a la unidad de GO de destilación directa, GO de la unidad de Coque, GO de la unidad de FCC y porcentaje de carga craqueada a la unidad respectivamente. En los casos 2 a 5 se han representado numéricamente los incrementos de esos porcentajes para cada caso.

- Resultados de planta piloto

Impacto de la calidad de carga sobre la temperatura de inicio de ciclo.

Para analizar el impacto de la calidad de la carga sobre la temperatura de inicio de ciclo, el esquema catalítico bajo estudio se sometió a las diferentes calidades de carga correspondientes a los casos estudiados.

Para cada calidad de carga se realizó un barrido de temperaturas en el rango 340°C-400°C y se caracterizaron completamente los productos obtenidos en cada condición. La temperatura de inicio de ciclo se calcula a partir de la curva generada de S vs Temperatura y es la que corresponde a un contenido de 10 ppm de azufre.

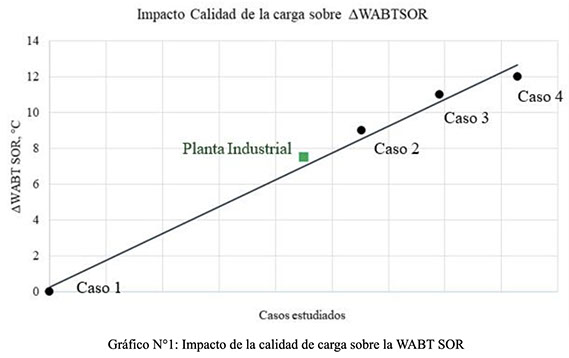

En el gráfico N°1 se muestran los resultados:

Como puede observarse al pasar del caso 1 al caso 2, es necesario incrementar la WABT SOR en 9°C para lograr la especificación del producto. Ese incremento de temperatura corresponde a cambios en la calidad de carga debido a la incorporación de GO proveniente de la unidad de coque y GO proveniente de la unidad de FCC a expensas de una disminución del GO proveniente de topping. Incrementos sucesivos del GO de coque solamente provocan aumentos de entre 2 y 3 grados por sobre el caso 2.

Una manera de validar los resultados obtenidos es agregando el punto correspondiente a la operación de la unidad, pudiéndose observar que el mismo cae dentro de la tendencia general observada.

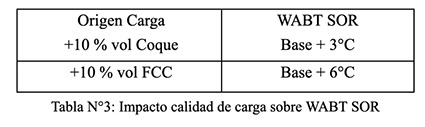

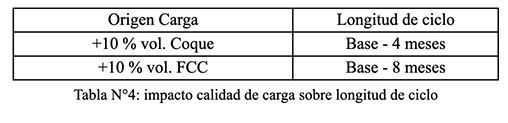

A partir de la información generada experimentalmente es posible predecir el impacto que tendrá un cambio porcentual de GO proveniente de Coque y/o FCC en la composición de la carga sobre el WABT SOR del esquema catalítico tal cual se resume en la tabla N°3:

- Impacto de la calidad de carga sobre la longitud de ciclo

También se analizó el impacto que la calidad de carga tiene en la longitud del ciclo estimada del esquema catalítico.

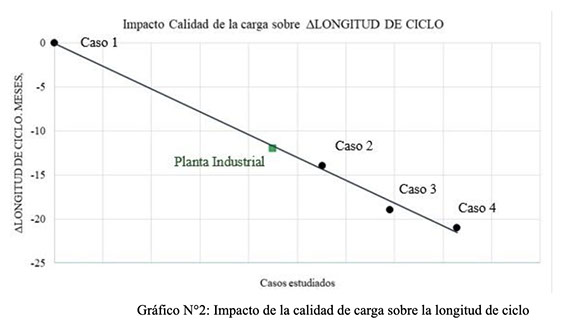

El gráfico N°2 muestra para los casos analizados experimentalmente la disminución en el ciclo de vida al cambiar la calidad de carga:

Al igual que en el caso anterior, al pasar del caso 1 al caso 2 se pierden aproximadamente 14 meses respecto de la longitud de ciclo del caso base debido a la desactivación ocasionada por la presencia de GO de coque y de FCC simultáneamente. Estas disminuciones en la longitud del ciclo son menores (del orden de 3-4 meses respecto al caso base) cuando solo cambia el contenido de GO de coque.

La información obtenida experimentalmente en este estudio se resume en la tabla N° 4:

- Impacto del Caudal de carga sobre la temperatura de inicio de ciclo y sobre la longitud de ciclo.

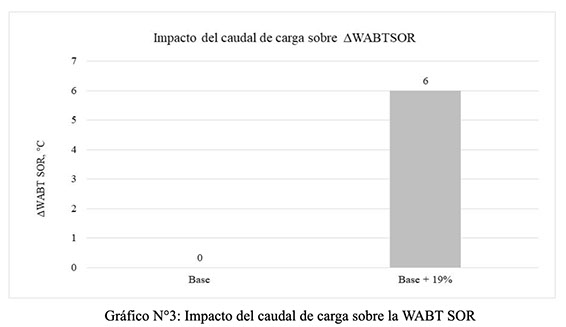

En el gráfico N°3 se observa el impacto de un cambio de aproximadamente 20% en el nivel de carga respecto al caso Base. En ambos casos la calidad de carga es idéntica y solo se ajustó la temperatura a la nueva condición para conseguir la especificación solicitada en el producto.

Se observa que aumentar un 20 % el nivel de carga para una calidad de carga fija incrementa la WABT SOR en 6°C.

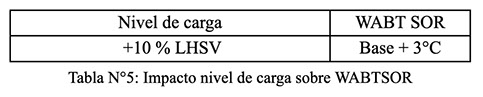

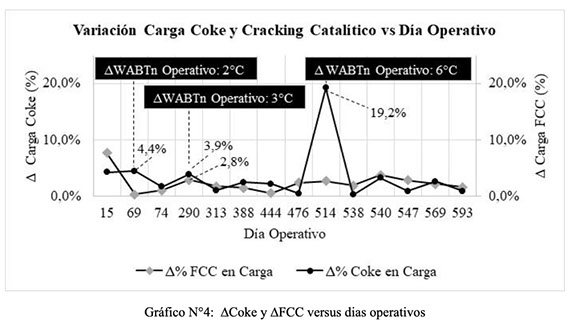

La tabla N°5 muestra el impacto del aumento de un 10% en el nivel de carga sobre la WABT SOR del esquema catalítico

Se estimó adicionalmente el impacto sobre la longitud de ciclo arrojando los resultados mostrados en la tabla N°6.

- Descripción de la unidad industrial

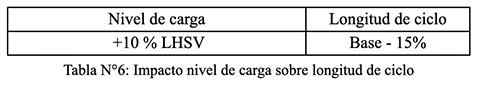

La unidad HTGB, ubicada en el CIIEM (Complejo Industrial Ingeniero Enrique Mosconi), corresponde a una planta de hidrotratamiento de gasoil diseñada bajo la tecnología Distillate Unionfining Process de UOP. La misma procesa una carga combinada proveniente de diversas corrientes del complejo: destilación atmosférica, destilación al vacío, craqueo catalítico (FCC) y unidades de coque. La alimentación se acumula y se bombea hacia la sección de reacción, se incorpora la principal corriente de hidrógeno de reciclo con control de flujo, para luego ingresar a un tren de intercambiadores de calor que aprovecha el calor generado en la reacción para precalentar la carga Luego en el horno de carga se ajusta la temperatura de entrada al reactor.

La mezcla de gasoil e hidrógeno ingresa al reactor, que cuenta con cuatro lechos catalíticos y control de temperatura por inyección de hidrógeno de quench en los lechos dos y tres.

Tras la reacción, el efluente caliente intercambia calor con las distintas corrientes de alimentación antes de pasar por una secuencia de enfriamiento y separación en etapas de alta y baja presión, donde se separan el gas de reciclo, aguas ácidas y el producto líquido.

El gasoil tratado se dirige al despojador para separarlo del hidrógeno disuelto, compuestos livianos y gases ácidos disueltos y una fracción de nafta agria. El aporte de calor se realiza por inyección de vapor de media presión en el fondo.

La fracción de tope (nafta) se enfría y se deriva hacia otras unidades de tratamiento de nafta, mientras que el fondo del despojador, tras ser enfriado, se envía a la torre de vacío de donde se obtiene el gasoil desulfurado y seco, que es finalmente enfriado y enviado a almacenamiento.

- Validación de los resultados de planta piloto

- Análisis de impacto

Con el objetivo de evaluar el efecto de las cargas craqueadas en el comportamiento del esquema catalítico de la unidad HTGB, se analizó la variación del Weighted Average Bed Temperature Normalizado, WABTn, en función del cambio relativo en el porcentaje de cargas craqueadas (FCC y Coke) durante el ciclo operativo de la unidad. También se analizó el impacto en el ciclo debido al incremento de velocidad espacial en el reactor (LHSV).

Este análisis compara el cambio en el WABTn observado en la operación de la unidad al cambiar la calidad de carga con el cambio en el WABT estimado en los ensayos de planta piloto. Para este análisis, se utilizaron datos de los dos primeros años de operación de la unidad, dado que los ensayos en planta piloto para estimar los efectos sobre la WABT se realizaron en condiciones de inicio de ciclo.

- Evaluación de Impacto de las cargas craqueadas sobre el WABT normalizado (WABTn)

Para analizar el impacto del porcentaje de cargas craqueadas sobre el WABT normalizado debieron filtrarse los datos para considerar únicamente aquellos días en los que el porcentaje de FCC y/o Coke en la carga mostraba una variación positiva respecto al día operativo anterior. Adicionalmente, se limitaron los datos a incrementos de WABTn entre 0 y 30°C, con el objetivo de excluir eventos asociados a arranques de unidad o ajustes de severidad no relacionados con la composición de la carga.

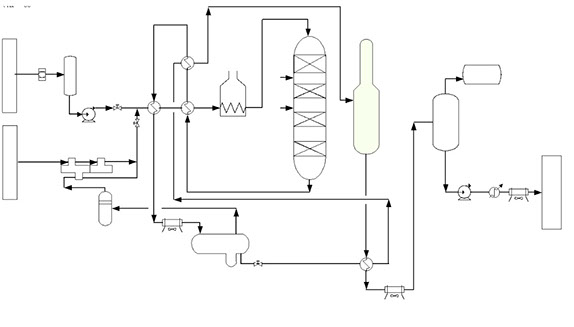

En el Gráfico N°4 se muestra el delta de porcentaje de carga craqueada (∆Coke y ∆FCC ejes verticales izquierdo y derecho respectivamente) indicando el correspondiente diferencial de WABTn operativo (∆WABTn) para diferentes puntos a lo largo del ciclo. Aquí se evidencia la necesidad de incremento de WABT como respuesta a los cambios de composición en la alimentación.

Tal como quedó expresado en la sección anterior, los estudios en planta piloto permitieron determinar el impacto de la calidad de la carga sobre la WABT SOR:

- Un incremento de 10% en carga de Coke genera un aumento de +3 °C en TSOR

- Un incremento de 10% en carga de FCC genera un aumento de +6 °C en TSOR

A partir de esta información es posible calcular según los resultados de planta piloto cuánto debería haberse incrementado el WABTn ante los cambios registrados de calidad de carga (ver gráfico N°4).

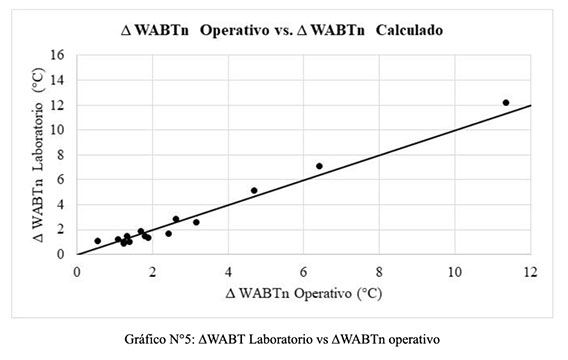

En el gráfico N°5 se muestra la relación entre el ∆WABTn_Operativo y ∆WABT SOR predicho por los resultados en planta piloto. Esta comparación permite evaluar el grado de correlación entre el modelo basado en datos de planta piloto y el comportamiento observado en la unidad. Como se observa, los puntos caen en torno a una línea diagonal (correlación perfecta) indicando una muy buena correlación entre ambos valores.

- Evaluación de impacto de las cargas craqueadas sobre longitud del ciclo operativo

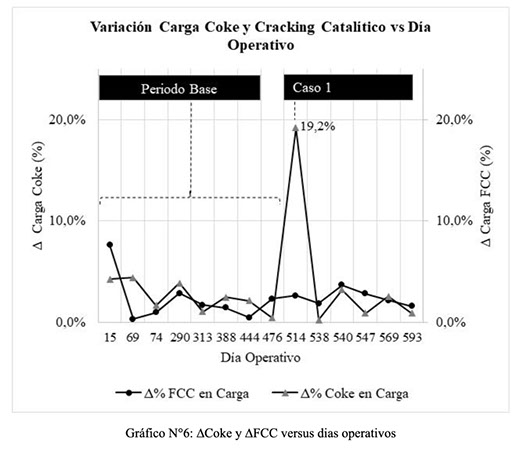

Para analizar el impacto de la calidad de carga sobre la longitud de ciclo se tomó como caso base operativo un periodo de 476 días en el cual la variación de cagas craqueadas de coque fue menor al 5%, y un caso 1 operativo, correspondiente al día 514, en el cual la variación de carga de Coke fue del 19%. En cada caso se filtraron los valores de WABTn de tal manera de obtener una tendencia creciente a lo largo del periodo, ya que los incrementos en las cargas de topping en la unidad reducen el WABT en ciertos momentos del ciclo.

En el Gráfico N°6 se representa la variación diaria en el porcentaje de carga craqueada, expresado como ∆Coke(%) y ∆FCC(%), tanto para el caso base operativo como para el caso 1 operativo considerado.

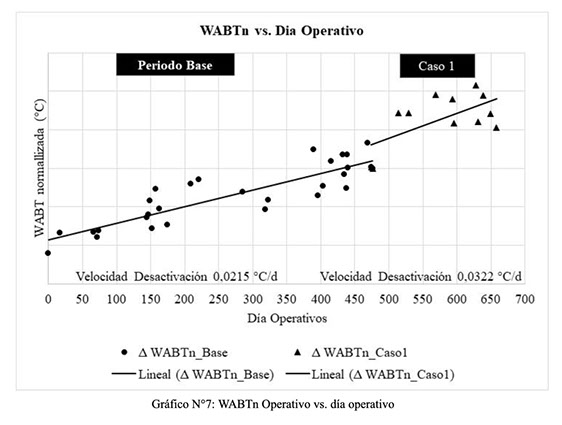

Adicionalmente, en el Gráfico N° 7 se representa la evolución temporal del WABTn operativo correspondiente a cada uno de los casos evaluados (caso base operativo y caso 1 operativo). La velocidad de desactivación en cada caso se obtuvo a partir de una regresión lineal sobre el conjunto de datos operativos.

Con estas estimaciones fue posible calcular la duración total del ciclo operativo para ambos escenarios, considerando un valor de WABTn al final del ciclo (EOR) igual a para ambos casos. A partir del punto de intersección de estas rectas con el valor EOR, se calculó la longitud del ciclo catalítico en días, y se determinó así la reducción de ciclo debida al incremento de carga craqueada en el caso 1.

La reducción así estimada se comparó con la predicha por los estudios de planta piloto discutidos en la sección anterior (tabla N° 4).

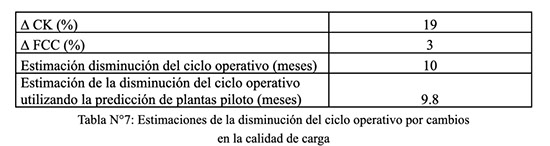

En la Tabla N°7 se observan los cambios en calidad de carga (tanto para GO de coque como GO de FCC) que se registran al pasar del caso base operativo al caso 1 operativo y la correspondiente disminución estimada del ciclo operativo.

Como puede observarse, existe una excelente correlación entre lo medido experimentalmente en plantas piloto y lo observado operativamente en la planta industrial.

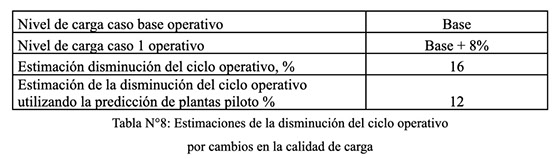

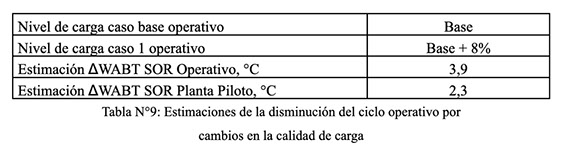

Evaluación de impacto de caudal de carga sobre longitud del ciclo operativo y WABT SOR

Para analizar el impacto del caudal de carga sobre la WABT SOR y la longitud del ciclo operativo se consideraron nuevamente un caso base operativo asociado a un periodo de 446 días con un caudal de carga promedio de Base y un caso 1 operativo con un caudal de carga promedio un 8% superior al base. Los datos fueron filtrados para tener variaciones de aporte de cargas craqueadas en el rango -1 a 1% para minimizar el efecto en el WABTn asociado a ajustes en porcentaje de cargas craqueadas en la carga.

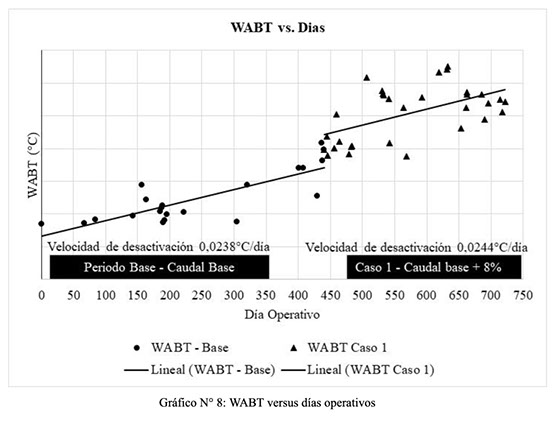

En el Gráfico N° 8 se observa la evolución temporal del WABT operativo correspondiente a cada uno de los casos evaluados. Para estimar la reducción en el ciclo de vida, se procedió de la misma forma que en el caso de cambios en la calidad de carga.

En la Tabla N° 8 se registran los cambios en los niveles de carga al pasar del caso base operativo al caso 1 operativo y la correspondiente disminución estimada del ciclo operativo.

Se observa que los resultados operativos predicen una disminución mayor que la observada en plantas piloto.

Esto se debe a que los resultados operativos están afectados no solo por un cambio en el nivel de caudal sino por el fenómeno de desactivación que ya ha sufrido el esquema catalítico al momento de analizar este cambio de caudal, diferencia en la calidad de la carga y en la especificación del producto.

Para el caso del impacto del cambio en caudal sobre WABT SOR, la tabla N°9 resume los resultados obtenidos.

Por la misma razón que en el caso anterior, se observa una discrepancia entre valores operativos y los predichos en planta piloto.

- Conclusiones

En el estudio realizado sobre el esquema catalítico de la unidad de Hidrotratamiento de Gas Oil del Complejo Industrial Ingeniero Enrique Mosconi (CIIEM) a través de pruebas en plantas piloto de YPF, se ha evaluado el impacto de variaciones en la calidad y el caudal de carga sobre la temperatura de inicio de ciclo y la longitud del ciclo del catalizador. Los resultados obtenidos permiten anticipar el comportamiento de la unidad ante cambios en la composición de la carga o cambios en el caudal, proporcionando información valiosa para la planificación técnica y económica.

La validación de los resultados obtenidos de los ensayos en la planta piloto de la GEEO con datos operativos reales ha confirmado la precisión de las predicciones realizadas en relación con los cambios de composición y una tendencia cualitativa respecto al incremento de carga.

Debe destacarse la importancia de realizar pruebas piloto como una herramienta que no solo facilita respuestas rápidas ante requerimientos operativos, sino que también sienta las bases para extender esta metodología a otras unidades y ampliar el rango de variables consideradas.

En resumen, el trabajo realizado aporta herramientas clave para optimizar el rendimiento y la vida útil del catalizador, asegurando una operación más eficiente y adaptable de la unidad de hidrotratamiento.

> SUMARIO DE NOTAS

AOG Expo 2025: Innovación, negocios e integración regional en una edición histórica

Jóvenes Oil & Gas: Nuevas generaciones para una industria en transformación

Financiar el futuro energético: El desafío detrás del desarrollo de Vaca Muerta

Encuentros con los CEOs:

Visión estratégica para el futuro energético

> Ver todas las notas